はじめに:会話できるAIの正体

最近、「チャットGPT」という言葉をよく耳にしませんか?まるで人と話しているように、質問に答えたり、文章を書いたりしてくれるAIです。

でも、どうしてそんなことができるのでしょう?その秘密は、「言葉の意味を見抜く力」にあります。

人間の“注意力”をまねるしくみ:アテンションとは?

人が文章を読むとき、すべての言葉を同じように見ているわけではありません。「自分に関係ありそうな部分」や「気になる言葉」に自然と注目していますよね。

AIも同じように、「どの言葉に注目するか」を判断しながら文章を読んでいます。このしくみが「アテンション(注意機構)」です。

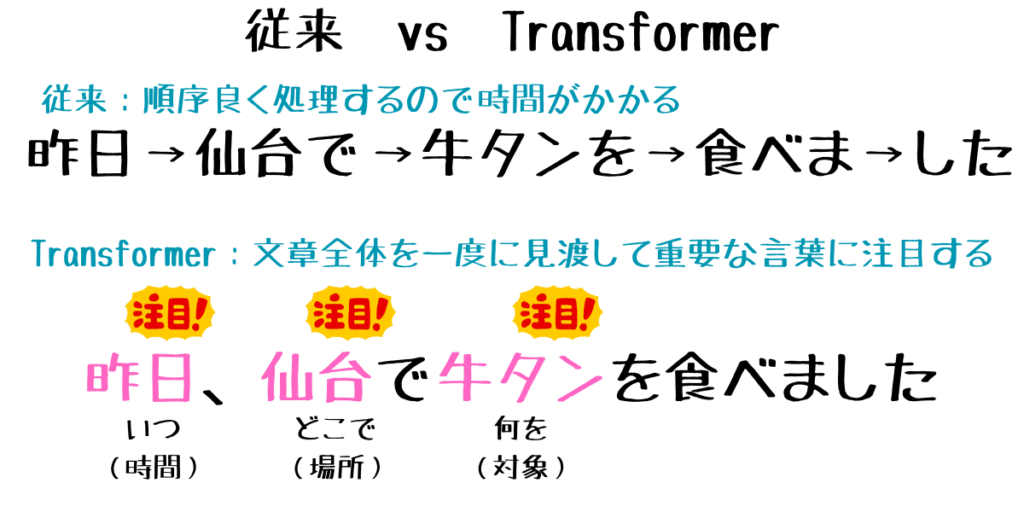

たとえば「昨日、仙台で牛タンを食べました」という文では、AIは「牛タン」「仙台」「昨日」に注目して、意味を理解しようとします。

自分の中で注目する力:自己注意(Self-Attention)

さらに進化したしくみが「自己注意(Self-Attention)」です。これは、文章の中で「自分自身のどの部分に注目すべきか」をAIが判断する方法です。

たとえば「昨日、仙台で牛タンを食べました」という文では、AIは「昨日」「仙台」「牛タン」の関係性を自分で整理して、文の意味を理解します。※関係が近いとか 遠いは 前回の【DL超入門5】自然言語処理で出てきた「方向」の話ですね。

このしくみのおかげで、AIは長い文章でも、前後のつながりを見ながら意味をつかめるようになりました。

AIの革命:Transformerの登場

2017年、AIの世界に「Transformer(トランスフォーマー)」という新しいモデルが登場しました。このモデルは、自己注意をベースにしていて、文章の中の重要な部分を一気に見渡すことができます。

それまでのAIは、言葉を順番にしか処理できませんでしたが、Transformerは「全体を見ながら、必要なところに注目する」ことができるのです。

まるで新聞を読むときに、見出しだけをパッと見て、気になる記事だけを読むような感覚です。

※トランスフォーマーっていうと車が人型ロボットに変身しそうですが(笑)、ここでは「ある形の言葉を、意味を理解しながら別の形に変える」しくみのことです。従来の技術では言葉を順番に理解する処理しかなかったのが、全体を見渡して意味を理解しながら変換する、というのが革命的で変換する者(トランスフォーマー)の登場で生成AIが大きく進化したきっかけとなりました。

チャットGPTはTransformerの進化形

チャットGPTは、このTransformerをベースにした「大規模言語モデル(LLM)」です。

- 大量の文章を学習している

- 自己注意で文の意味を理解する

- 人間のように自然な文章を生成できる

このしくみがあるからこそ、チャットGPTは「会話ができるAI」として、世界中で使われるようになったのです。

チャットGPTは、世代を重ねるごとに“脳の容量”が爆発的に増えています。 たとえば、初期のGPT-1は約1億個のパラメータ(知識のかたまり)でしたが、GPT-2では15億、GPT-3では1750億、そしてGPT-4ではさらにその先へ。 これはまるで、小さな図書館 → 大学の図書館 → 国会図書館 → 世界中の図書館を一気に読んだAIへと進化しているようなものです。 だからこそ、私たちの質問に対して、より自然で深い答えが返ってくるようになったのです。 ※パラメータは前回の超入門5自然言語処理で つまみ と表現したものですね。

<もう少し深堀> チャットGPTの理解と回答のメカニズム

抜けている言葉は、文章の空気を読む

「昨日、仙台で牛タンを食べました」という文を、チャットGPTは以下のように整理します。

- 昨日:時間(いつ)

- 仙台で:場所(どこで)

- 牛タンを食べました:行動(何をした)

この文には主語が明示されていませんが、チャットGPTは「この文を話している人(=文脈上の話者)」が牛タンを食べたと推論します。これは、Transformerの「自己注意(Self-Attention)」というしくみが働いて、文の構造と関係性を整理しているからです。

「昨日、仙台で牛タンを食べたのは誰ですか?」と聞いたら?

質問を答えるとき、チャットGPTは以下のようなステップで処理します。

- 質問の構造を理解:「誰が?」という主語を尋ねていると認識

- 文脈を参照:直前の文や会話履歴から、誰が牛タンを食べたかを推測

- 回答を生成:

- 文脈が明確なら「私です」と答える

- 文脈が不明なら「情報が不足しています」と返す

つまり、チャットGPTは単語の意味だけでなく、会話の流れや前後関係を踏まえて自然な応答を生成しているのです。「昨日、仙台で牛タンを食べたのは誰か?」という問いに答えられるのは、単なる言葉の意味理解だけでなく、文脈推論と自己注意の力があるからです。

まとめ:アテンションから始まるAIの進化

| 用語 | やさしい意味 | 役割 |

|---|---|---|

| アテンション | どの言葉に注目するかを決めるしくみ | 文の意味を見抜く第一歩 |

| 自己注意 | 自分の文章の中で注目ポイントを探す力 | 前後のつながりを理解する |

| Transformer | 全体を見渡して注目するAIの新しい脳 | 長文でも自然に理解できる |

| チャットGPT | Transformerをベースにした会話AI | 人と話すように使えるAI |

関連記事(シリーズ)

- 【DL超入門1】ディープラーニングとは?初心者でもわかるAIの基本と仕組み

- 【DL超入門2】ディープラーニングの学習方法 ― 回帰・分類・強化学習をわかりやすく解説

- 【DL超入門3】AI開発のカギはデータ準備 ― 良質なデータがディープラーニングを支える

- 【DL超入門4】AIが学習する仕組み ― 誤差最小化と過学習の問題をわかりやすく解説

- 【DL超入門5】「自然言語処理」ってなに?

- 【DL超入門6】ChatGPTってなに?

- 【DL超入門7】画像を処理するということは?CNNとGANのしくみをやさしく解説

- 【DL超入門8】動画(時系列データ)の扱い方 ― RNN(再帰型ニューラルネットワーク)とは?

(補足)この記事で扱ったキーワード(G検定シラバスベース)

大規模言語モデル, Transformer, 自己注意機構, アテンション, 位置エンコーディング, エンコーダ・デコーダ, GPT, BERT, 応答生成, 文脈理解

コメント